Asterisk + ИИ: Как создать голосового агента, который заменит оператора

Простыми словами: Зачем бизнесу нужен AI-агент на Asterisk?

Традиционные системы IVR (Interactive Voice Response) доживают свой век. Клиенты устали слушать бесконечные меню: «Нажмите 1 для связи с отделом продаж, нажмите 2, чтобы узнать статус заказа». Это долго, неудобно и часто приводит к тому, что человек просто вешает трубку.

На смену кнопочным меню приходит Asterisk AI — интеллектуальный голосовой агент, способный вести естественный диалог. Это не просто система распознавания ключевых слов, а полноценный собеседник, который понимает контекст, интонацию и намерения звонящего.

Внедрение такого решения позволяет автоматизировать рутину: запись на прием, проверку баланса, первичную квалификацию лидов или ответы на часто задаваемые вопросы. Операторы колл-центра освобождаются от шаблонных задач и подключаются только тогда, когда требуется эмпатия или решение нестандартной проблемы.

- ИИ-агент работает круглосуточно без перерывов и выходных.

- Система масштабируется мгновенно: бот может принять 100 звонков одновременно, в то время как штат операторов ограничен.

Давайте разберёмся, как построить такую систему своими руками ↓

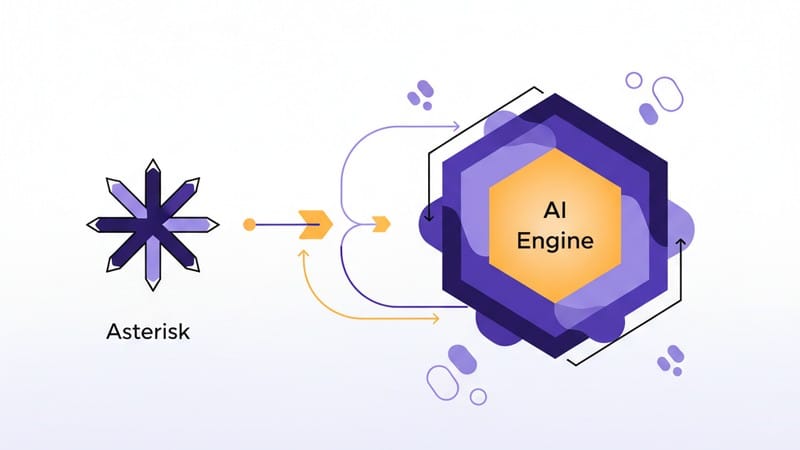

Секреты архитектуры: Стыковка Asterisk (AGI/ARI) и мощных AI-движков

Главная сложность при создании голосового бота — это задержка (latency). Чтобы диалог выглядел живым, ответ системы должен приходить быстрее, чем за секунду. Стандартные методы интеграции через файлы или простые AGI-скрипты здесь часто проигрывают.

Современная интеграция Asterisk и нейросетей строится на потоковой передаче аудио. В проекте, который мы рассматриваем в качестве основы (Asterisk AI Voice Agent), используется технология Audiosocket или RTP. Это позволяет передавать медиапоток из Asterisk во внешний сервис управления диалогом в реальном времени.

Архитектура выглядит следующим образом:

- Asterisk принимает звонок.

- Через Dialplan звонок направляется в приложение (например,

AudiosocketилиExternalMedia), которое открывает TCP-сокет к серверу приложения. - Сервер приложения (Python/Go/Node.js) принимает аудиопоток.

- Поток направляется в ASR (Speech-to-Text) для транскрибации.

- Текст отправляется в LLM (Large Language Model) для генерации ответа.

- Ответ LLM превращается в звук через TTS (Text-to-Speech) и отправляется обратно в трубку клиенту.

Важно понимать, что Asterisk здесь выступает только как шлюз телефонии. Вся логика ("мозги") вынесена в отдельный контейнеризированный сервис. Это дает гибкость: вы можете менять модели распознавания или синтеза речи, не перенастраивая саму АТС.

Разработка без боли: ASR, NLU и TTS – как заставить бота говорить и понимать

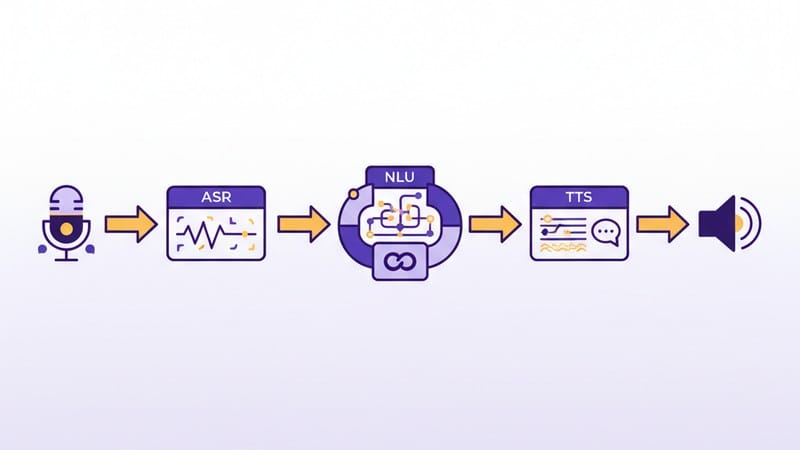

Чтобы создать полноценного Asterisk Voice Agent, нам нужно собрать пайплайн из трех ключевых компонентов: NLU ASR TTS. Разберем каждый этап и инструменты, которые можно использовать.

1. ASR (Automatic Speech Recognition)

Это "уши" вашего бота. Задача компонента — превратить аудиопоток в текст с минимальной задержкой. Для телефонии критически важна поддержка streaming-режима (распознавание по мере поступления звука), а не загрузка целых файлов.

Популярные решения:

- Deepgram: Один из самых быстрых движков на рынке, отлично подходит для real-time диалогов.

- Whisper (OpenAI): Обеспечивает высокое качество, но в стандартной реализации может иметь задержки. Существуют оптимизированные версии (например, Faster-Whisper), которые можно развернуть локально.

- Google Speech-to-Text: Классическое решение с хорошей поддержкой русского языка.

2. NLU/LLM (Natural Language Understanding)

Это "мозг". Здесь текст превращается в смысл и генерируется ответ. Сейчас стандартом де-факто стало использование больших языковых моделей (LLM).

Вы можете подключить:

- OpenAI (GPT-3.5-turbo/GPT-4o): Отличное понимание контекста и инструкций.

- Groq: Сервис, предоставляющий доступ к open-source моделям (Llama 3, Mixtral) с невероятно высокой скоростью инференса.

- Локальные модели: Если важна приватность данных, можно использовать Llama 3 или Qwen, развернутые на собственных GPU через Ollama или vLLM.

- LLM должна поддерживать "Function Calling" (вызов инструментов), если вы хотите, чтобы бот мог, например, проверить статус заказа в базе данных, а не просто болтать.

3. TTS (Text-to-Speech)

Это "голос". Синтез речи должен быть быстрым и естественным. Роботизированный голос 90-х годов сразу убивает доверие к сервису.

Варианты:

- OpenAI TTS: Качественное звучание, прост в интеграции.

- Azure AI Speech: Огромный выбор голосов и настроек интонации.

- Cartesia: Новые сверхбыстрые модели для генерации речи (Sonic), ориентированные на диалоговые системы.

Ключ к успеху — использование потоковой передачи на всех этапах. Как только LLM сгенерировала первое предложение, TTS уже должен начинать его озвучивать, не дожидаясь конца всего ответа ↓

Практика: Пошаговая настройка диалогового бота для вашего контакт-центра

Перейдем к практике. Мы будем использовать open-source решение Asterisk-AI-Voice-Agent от hkjarral. Это модульная платформа, которая уже умеет связывать Asterisk с популярными AI-сервисами.

Для развертывания вам потребуется сервер с Linux (Ubuntu/Debian) и установленные Docker и Docker Compose.

Шаг 1: Клонирование репозитория

Откройте терминал и скачайте исходный код проекта.

git clone https://github.com/hkjarral/Asterisk-AI-Voice-Agent.git

cd Asterisk-AI-Voice-Agent

Шаг 2: Предварительная проверка (Pre-flight Check)

В проекте есть скрипт, который проверяет наличие необходимых утилит и автоматически создает конфигурационные файлы. Это критически важный этап.

Скрипт создаст файл .env и сгенерирует безопасный ключ JWTSECRET.

# Делаем скрипт исполняемым

chmod +x preflight.sh

# Запускаем с флагом автоматического исправления

sudo ./preflight.sh --apply-fixes

- Внимательно изучите вывод команды. Если скрипт сообщает об ошибках зависимостей, установите их перед продолжением.

Шаг 3: Настройка окружения

Откройте созданный файл .env в любом текстовом редакторе (например, nano или vim). Вам нужно указать API-ключи для сервисов, которые вы планируете использовать.

nano .env

Найдите секции для провайдеров (OpenAI, Deepgram, Twilio и т.д.) и вставьте свои ключи. Например:

OPENAIAPIKEY=sk-proj-...DEEPGRAMAPI_KEY=...

Шаг 4: Запуск контейнеров

Проект использует Docker Compose для оркестрации сервисов. Основной стек включает в себя сервер приложения и базу данных (если требуется).

docker-compose up -d

После успешного запуска вы можете проверить статус контейнеров командой docker ps.

Шаг 5: Доступ к Admin UI

После старта вам станет доступен веб-интерфейс для управления агентами.

Чтобы узнать, на каком порту запустился интерфейс, проверьте файл docker-compose.yml или посмотрите логи контейнера. Обычно порт пробрасывается на хост-машину.

В браузере введите IP-адрес вашего сервера и соответствующий порт. В этом интерфейсе вы сможете:

- Создавать новых агентов.

- Настраивать системные промпты (инструкции для LLM).

- Выбирать голос и язык.

- Просматривать логи звонков.

Шаг 6: Настройка Dialplan в Asterisk

Теперь нужно научить Asterisk отправлять звонки в нашего бота. Если вы используете «чистый» Asterisk, добавьте следующий контекст в extensions.conf:

[ai-agent]

exten => 100,1,Answer()

same => n,Audiosocket(uuid,127.0.0.1:8080) ; Укажите IP и порт, где слушает приложение

same => n,Hangup()

Если у вас FreePBX, вам потребуется использовать модуль Custom Destinations, чтобы направить входящий маршрут на этот кастомный контекст.

Масштабирование: Как тестировать и оптимизировать ИИ-агентов для больших нагрузок

Когда вы запускаете тестового бота, все работает быстро. Но что произойдет, когда одновременно позвонят 50 человек? Без оптимизации система может "захлебнуться", а задержки станут неприемлемыми.

Вот основные стратегии оптимизации:

1. Балансировка нагрузки

Не запускайте все на одном сервере. Разделите компоненты:

- Asterisk: должен заниматься только SIP-сигнализацией и медиа-транзитом.

- AI Backend: вынесите обработку логики в кластер Kubernetes или Docker Swarm.

- Базы данных: используйте Redis для хранения контекста диалога (истории сообщений), так как это быстрее, чем обращаться к диску.

2. Кэширование ответов

Многие вопросы пользователей повторяются ("Сколько стоит доставка?", "Где мой заказ?").

Используйте семантическое кэширование. Если вопрос пользователя по смыслу совпадает с ранее заданным, можно отдать готовый ответ (аудиофайл), не тратя деньги на LLM и время на TTS.

3. Обработка прерываний (Barge-in)

Пользователи часто перебивают робота. Если бот продолжает говорить, когда клиент уже задает новый вопрос, это раздражает.

Ваша архитектура должна поддерживать barge-in:

- VAD (Voice Activity Detection) должен мгновенно определять речь пользователя.

- Система должна посылать сигнал "Stop" в TTS и очищать буфер воспроизведения Asterisk.

4. Мониторинг метрик

Следите не только за загрузкой CPU, но и за бизнес-метриками. Настройте дашборды (например, в Grafana) для отслеживания:

- TTFT (Time to First Token): как быстро LLM начинает отвечать.

- Latency: общая задержка от конца фразы клиента до начала звука от бота.

- Стоимость минуты: расходы на API провайдеров.

Сравнение: Asterisk против платных решений – что выгоднее для вашего бизнеса?

На рынке существует множество готовых облачных платформ для создания голосовых ботов (Retell AI, Vapi и другие). Зачем же мучиться с настройкой собственного сервера на Asterisk?

Давайте сравним подходы ↓

Платные облачные решения (SaaS)

Плюсы:

- Быстрый старт: можно собрать бота за 15 минут в визуальном редакторе.

- Нет поддержки инфраструктуры: не нужно думать о серверах, обновлениях и Docker.

- Готовые интеграции: часто уже есть коннекторы к CRM.

Минусы:

- Цена: вы платите высокую наценку за каждую минуту разговора сверх стоимости AI-провайдеров.

- Приватность: данные ваших клиентов проходят через третьи руки.

- Зависимость: если сервис изменит цены или API, вы станете заложником ситуации.

Собственное решение (Self-hosted на Asterisk)

Плюсы:

- Полный контроль: вы сами выбираете, какие модели использовать (GPT-4, Claude или Llama).

- Стоимость: вы платите только прямую цену за использование API (STT/LLM/TTS) и аренду сервера. При больших объемах это в разы дешевле.

- Безопасность: можно развернуть локальные модели (Whisper, Llama) и данные вообще не покинут ваш контур.

- Гибкость: возможность дописать любой код и интегрировать любую внутреннюю систему без ограничений вендора.

Минусы:

- Сложность: требуются компетенции DevOps и разработчика.

- Ответственность: поддержка работоспособности лежит полностью на вашей команде.

Вывод: Если вам нужно быстро протестировать гипотезу или трафик небольшой — облачные решения подойдут идеально. Но если вы строите серьезный контакт-центр с тысячами звонков и высокими требованиями к безопасности данных, собственная разработка на базе Asterisk Voice Agent — это единственно верный путь, который окупится в долгосрочной перспективе.

Внедрение ИИ в телефонию — это уже не будущее, а стандарт индустрии. Начав использовать эти технологии сегодня, вы получите значительное преимущество перед конкурентами, которые все еще заставляют клиентов "нажимать звездочку".